Материалы по тегу: google cloud platform

|

13.02.2026 [12:05], Руслан Авдеев

В мирных целях и не только: Google Cloud анонсировала участие в космических проектах ReOrbit и Starfish SpaceGoogle Cloud присоединилась к проектам спутниковых облачных вычислений: Space Cloud от производителя спутников ReOrbit и Otter от компании Starfish Space, сообщает Datacenter Dynamics. Обе программы — двойного назначения, т.к. говорится о способности оборудования содействовать «обеспечению национальной безопасности». В том и другом случаях Google готова обеспечить техническую экспертизу для разработки ПО и облачных технологий. Ранее ReOrbit из Хельсинки анонсировала облачную сеть Space Cloud — спутники предназначены для безопасной обработки и передачи данных с помощью квантового распределения ключей (QKD). Технические подробности о системе обещают раскрыть в апреле 2026 года. ReOrbit привлекла Google для создания спутниковой облачной сети по образцу наземных дата-центров последней. ReOrbit сообщает, что объединение её программно-управляемой спутниковой архитектуры и опыта Google в сфере ИИ и облачной оркестрации позволит создать инфраструктуру для удовлетворения критической потребности в суверенитете данных Европы и НАТО. ReOrbit намерена разделить систему на сети, оптимизированные для государственных и частных клиентов. Коммерческое «пространство» для данных дистанционного зондирования Земли и результатов периферийных вычислений будет отделено от суверенной сферы, связанной с обеспечением национальной безопасности.

Источник изображения: ReOrbit Сервисный спутник Otter компании Starfish Space представляет собой небольшой аппарат для обслуживания спутников и продления срока их службы, а также их утилизации по окончании их жизненного цикла. Эксплуатация предусматривается преимущественно на геосинхронной орбите. Как сообщает компания, её целью является недорогое и доступное обслуживание спутников. Для этого необходим принципиально новый подход с акцентом на программное обеспечение. Google Cloud может предоставить масштабируемые высокопроизводительные вычисления, необходимые для быстрой и надёжной организации миллионов симуляций. После успешного демонстрационного запуска спутников Otter Pup компания Starfish Space заключила соглашение с NASA, Космическими силами США, Агентством космического развития (SDA), входящего в космические силы, а также нидерландским оператором космической связи SES. Первая в мире миссия, предусматривающая продление срока службы космического спутника, проведена ещё в 2020 году подразделением Northrop Grumman. Тогда корабль «Прогресс» доставил на орбиту демонстрационный образец MEV-1. Аппарат предназначался для перемещения на заданную геосинхронную орбиту спутника Intelsat IS-901. Тот оставался на орбите 2025 года, после чего MEV-1 перевёл его на новую орбиту для утилизации. Высока вероятность, что со временем подобные миссии по изменению орбит и обслуживанию позволят ремонтировать и модернизировать спутники, продлевая срок их службы и повышая безопасность космического пространства. Для подготовки специального ПО используются масштабные симуляции с использованием методов Монте-Карло в Google Cloud для моделирования различных сценариев работы в космическом пространстве. Google занимается собственными космическими проектами. В ноябре 2025 года компания анонсировала Project Suncatcher по созданию масштабируемой ИИ-инфраструктуры в космосе.

05.02.2026 [22:55], Владимир Мироненко

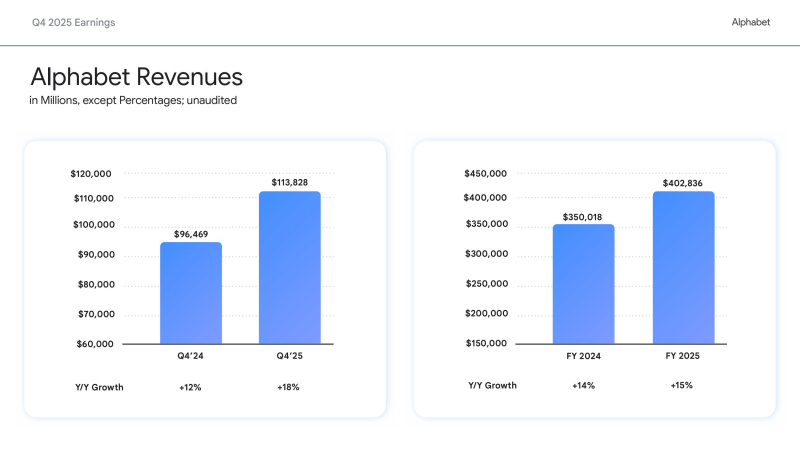

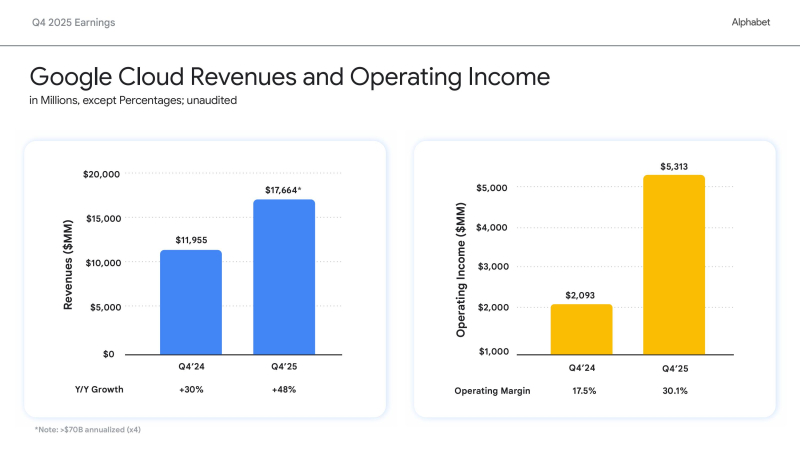

Вложимся в ИИ, а там посмотрим: Alphabet удвоит капзатраты в 2026 году на фоне полуторакратного роста выручки Google CloudХолдинг Alphabet, включающий компанию Google, объявил финансовые результаты IV квартала и всего 2025 финансового года, закончившегося 31 декабря 2025 года. Финансовые результаты компании за IV квартал превзошли прогнозы Уолл-стрит как по выручке, так и по прибыли. Как сообщил Alphabet, это отражает сильную динамику развития бизнеса и ускорение роста как в сервисах Google, так и в Google Cloud. Видимо, поэтому холдинг готов нарастить инвестиции в ИИ-инфраструктуру. Выручка за квартал выросла год к году на 18 % до $113,83 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $111,43 млрд (по данным CNBC). Разводнённая прибыль на акцию холдинга за квартал выросла до $2,82 с $2,15 в предыдущем году, что также выше прогнозируемых Уолл-стрит $2,63 (по данным Reuters). Годовая выручка достигла $402,8 млрд, а разводнённая прибыль на акцию — $10,81. Финансовый директор Alphabet Анат Ашкенази (Anat Ashkenazi) заявила, что Alphabet будет осуществлять свои инвестиции в 2026 году «таким образом, чтобы сохранить очень здоровое финансовое положение организации». Облачный бизнес компании — Google Cloud — продемонстрировал впечатляющий рост в IV квартале, главным образом за счёт роста доходов Google Cloud Platform (GCP) по основным продуктам, ИИ-инфраструктуре и решениям для генеративного ИИ, увеличившись на 48 % до $17,66 млрд, что превзошло ожидания аналитиков StreetAccount в размере $16,18 млрд. Это был самый высокий темп роста за более чем четыре года. Операционная прибыль сегмента составила $5,31 млрд против $2,09 млрд годом ранее. Рост облачного подразделения «впервые за несколько лет оказался значительно выше, чем у Microsoft Azure», что помогло материнской компании оправдать увеличение капитальных затрат, сказал Гил Лурия (Gil Luria), аналитик D.A. Davidson. Сообщается, что акции Alphabet поначалу упали после отчёта на 6 %, поскольку объявление, что капитальные затраты в 2026 году составят от $175 до $185 млрд, что примерно вдвое больше, чем $91,4 млрд, инвестированных компанией в 2025 году и выше прогноза Уолл-стрит в $115,26 млрд, вызвало сомнения инвесторов в масштабах и устойчивости инвестиционных планов холдинга в связи с ростом капзатрат. Впрочем, в течение дня инвесторы отыграли падение акций Alphabet до 1 %, сопоставив рост расходов с резким ростом выручки и прибыли. Ожидается, что Alphabet и её конкуренты из числа крупных технологических компаний в совокупности потратят более полутриллиона долларов на ИИ в этом году. Meta✴ на прошлой неделе объявила об увеличении инвестиций в разработку ИИ в этом году на 73 %, в то время как Microsoft также сообщила о рекордных квартальных капитальных затратах. Сообщается, что капзатраты Meta✴ составят $125 млрд (по сравнению с $70 млрд в 2025 году), Alphabet — $180 ($91 млрд), Amazon — $175 млрд ($125 млрд), Microsoft — $145 млрд ($83 млрд), Oracle — $55 млрд ($35 млрд). То есть только эти пять компаний увеличат в 2026 году капзатраты по сравнению с прошлым годом почти на $300 млрд — с $404 млрд до $680 млрд. «Мы испытывали ограничения в поставках, даже несмотря на то, что наращивали наши мощности», — сказал гендиректор Сундар Пичаи (Sundar Pichai). — Очевидно, что наши капитальные затраты в этом году — это взгляд в будущее». «Мы видим, что наши инвестиции в ИИ и инфраструктуру стимулируют рост выручки», — отметил он в ходе общения с аналитиками, дополнительно высказав опасения, что Alphabet столкнётся с продолжающимися ограничениями в поставках в течение всего года. Пичаи отметил, что почти 75 % клиентов Google Cloud используют вертикально оптимизированный ИИ компании — от чипов и моделей до ИИ-платформ и корпоративных ИИ-агентов, которые обеспечивают высокую производительность, качество, безопасность и экономичность. «Эти клиенты, использующие ИИ, применяют в 1,8 раза больше продуктов, чем те, кто этого не делает, что позволяет нам диверсифицировать портфель продуктов, углублять отношения с клиентами и ускорять рост доходов», — подчеркнул гендиректор. Аналитики Barclays отметили: «Рост облачных сервисов поразителен, если измерять его любыми показателями: выручка, портфель заказов, количество полученных токенов API, внедрение Gemini в корпоративном секторе. Эти показатели в сочетании с прогрессом DeepMind в разработке моделей начинают оправдывать 100-% увеличение капитальных затрат в 2026 году». В RBC Capital Markets заявили, что динамика развития Gemini и резкий рост выручки Google Cloud в IV квартале являются «достаточными доказательствами, оправдывающими увеличение инвестиций» в 2026 году. Аналитики Deutsche Bank отметили, что Alphabet «поразила мир» своим масштабным планом капитальных затрат. «В условиях нынешних перемен в технологическом секторе неясно, хорошо это или плохо», — написали они. Добавим, что выручка сегмента Google Services — включающего доходы от рекламы в поиске и YouTube, на который приходится большая часть выручки Alphabet — выросла за квартал лишь на 14 % по сравнению с предыдущим годом до $95,86 млрд, что выше прогнозируемых $94,9 млрд согласно консенсус-прогнозам аналитиков, опрошенных Bloomberg. Акции Alphabet взлетели более чем на 70 % за последние шесть месяцев, и в прошлом месяце холдинг стала четвёртой компанией в истории, достигшей рыночной капитализации в $4 трлн, присоединившись к NVIDIA, Microsoft и Apple, отметил ресурс Forbes.

05.01.2026 [18:25], Владимир Мироненко

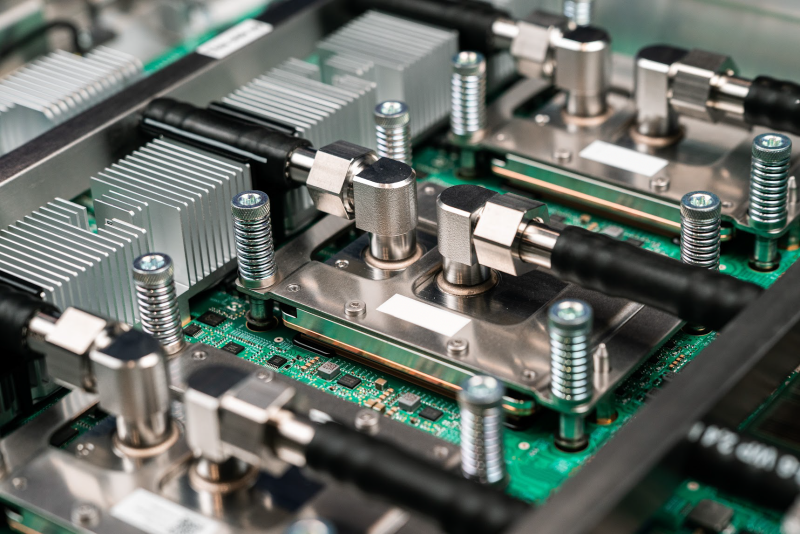

Anthropic купит сотни тысяч ИИ-ускорителей Google TPU напрямую у BroadcomAnthropic приобретёт около 1 млн Google TPU v7 (Ironwood) с тем, чтобы запустить их на контролируемых ею объектах, сообщил в соцсети Х ресурс SemiAnalysis. Ранее сообщалось, что примерно 400 тыс. компания купит напрямую у Broadcom в стойках за примерно $10 млрд, а остальные 600 тыс. единиц TPU v7 будут доступны посредством Google Cloud Platform (GCP) в рамках сделки на сумму около $42 млрд, что составляет большую часть увеличения портфеля заказов GCP на $49 млрд или на 46 %, о котором сообщалось в отчёте за III квартал 2025 года. В случае с закупаемыми напрямую ускорителями TeraWulf и Cipher Mining будут ответственны за инфраструктуру ЦОД, а европейское неооблако Fluidstack будет заниматься настройкой оборудования на месте, прокладкой кабелей, первичным тестированием, испытаниями при приёмке и удалённым обслуживанием, освободив Anthropic от бремени управления физическими серверами. По слухам, эти системы получат упрощённую топологию интерконнекта. Сделки Fluidstack с обоими операторами ЦОД, ранее ориентированными на криптомайнинг, финансово застрахованы Google, которая к тому же является совладельцем TeraWulf и может получить долю в Cipher Mining. Любопытно, что оба оператора частично связаны и с AWS. Хотя Google закупает TPU через Broadcom, которая тоже хочет свою маржу, это всё равно лучше, чем та маржа, что требует NVIDIA не только за продаваемые ускорители, но и за всю систему целиком, включая процессоры, коммутаторы, сетевые карты, системную память, кабели, разъёмы и т.п. По оценкам, SemiAnalysis, совокупная стоимость владения (TCO) на один чип Ironwood для полной конфигурации с топологией 3D-тор примерно на 44 % ниже, чем у серверов GB200, что с лихвой компенсирует примерно 10-% отставание TPU от GB200 по пиковым производительности и пропускной способности памяти. При этом реальная, а не теоретическая производительность (Model FLOP Utilization, MFU) у TPU, по мнению SemiAnalysis, может быть выше, чем у конкурентов. Основная причина заключается в том, что заявляемые NVIDIA и AMD показатели производительности (Флопс) значительно завышены. Даже в синтетических тестах, значительно отличающиеся от реальных рабочих нагрузок, Hopper достиг лишь около 80 % пиковой производительности, Blackwell — около 70 %, а серия MI300 от AMD — 50–60 %. Как полагают в SemiAnalysis, даже сдача ускорителей на сторону выгодна Google за счёт того, что TCO в пересчёте на час аренды может быть примерно на 30 % ниже, чем у GB200, и примерно на 41 % ниже, чем у GB300. Несмотря на высокий спрос, Google не может поставлять TPU в желаемом темпе, отметил SemiAnalysis, полагая, что основная проблема заключается в бюрократии Google — от первоначальных обсуждений до подписания генерального соглашения об оказании услуг (Master Services Agreement) проходит до трёх лет. Неооблака, включая Fluidstack, отличаются гибкостью и оперативностью, что облегчает им взаимодействие с новыми поставщиками услуг дата-центров, например, с реорганизованными криптомайнерами. Однако у неооблаков, среди инвесторов которых числится NVIDIA, таких как CoreWeave, Nebius, Crusoe, Together, Lambda, Firmus и Nscale, есть существенный стимул не внедрять конкурирующие технологии в своих дата-центрах: TPU, ускорители AMD и даже коммутаторы Arista — всё это под запретом. Это оставляет огромную нишу на рынке хостинга TPU, которая в настоящее время заполняется комбинацией майнеров криптовалют и Fluidstack, сообщил SemiAnalysis. По мнению SemiAnalysis, в ближайшие месяцы всё большему числу компаний-неооблаков предстоит принимать непростое решение между развитием возможностей хостинга TPU и получением квот на новейшие и лучшие системы NVIDIA Rubin.

24.12.2025 [12:14], Сергей Карасёв

Google Cloud и Palo Alto Networks заключили партнёрское соглашение на $10 млрдОблачная платформа Google Cloud и калифорнийская компания Palo Alto Networks, специализирующаяся на услугах в области информационной безопасности, по информации Reuters, заключили многолетнее соглашение о сотрудничестве. Как сообщили осведомлённые лица, в договоре прописано обязательство Palo Alto Networks выплатить Google Cloud сумму, «приближающуюся к $10 млрд». На сегодняшний день это крупнейшая сделка в истории облачной площадки. Сами компании отказались комментировать финансовые условия контракта. По словам президента Palo Alto Networks Би Джей Дженкинса (BJ Jenkins), часть средств в рамках соглашения пойдёт на перенос существующих сервисов компании в облако Google Cloud. Кроме того, значительная сумма выделяется на развёртывание новых сервисов в сфере кибербезопасности, использующих технологии ИИ. Отмечается, что ИИ оказывает двоякое влияние на сектор ИБ. С одной стороны, нейросетевые технологии помогают в выявлении уязвимостей и новых атак, а также в автоматизации рутинных задач по защите IT-инфраструктуры. Но, с другой стороны, злоумышленники также берут на вооружение ИИ для написания вредоносного кода, поиска дыр в ПО и пр. Кибератаки всё чаще совершаются с использованием тех же инструментов генеративного ИИ, которые поставщики ИБ-услуг применяют для усиления защиты. На фоне стремительного расширения ИИ-рынка и Google, и Palo Alto Networks инвестируют значительные средства в решения нового поколения для обеспечения безопасности. В частности, Google в марте уходящего года объявила о покупке стартапа Wiz, работающего в области информационной безопасности: сумма сделки составляет $32 млрд. В свою очередь, Palo Alto Networks внедрила решения на основе ИИ в октябре, после чего сообщила о планах по покупке разработчика средств мониторинга для ИИ-платформ Chronosphere за $3,35 млрд.

17.12.2025 [09:16], Руслан Авдеев

Oracle готова размещать чужое оборудование в своих ЦОДOracle заявила, что рассматривает различные модели заработка на своих дата-центрах. В числе прочего не исключена возможность размещения в её ЦОД собственного оборудования клиентов, передаёт Datacenter Dynamics. Кроме того, компания намерена расширить предложение Oracle Database@Google Cloud. По словам руководства компании, в некоторых случаях клиенты желают использовать собственное оборудование в её дата-центрах, и в таких случаях компания не несёт капитальные затраты на закупку «железа» компания тогда не несёт, а расходы сводятся к содержанию непосредственно ЦОД, сети и персонала. Но компания рассматривает и другие варианты, в том числе авансовые платежи за оборудование из собственных средств или даже сдача в аренду поставщикам чипов их же собственного оборудования в дата-центрах Oracle. Для Oracle последняя модель в новинку, однако у «неооблачных» провайдеров уже есть такие сделки. Так, NVIDIA заключила с CoreWeave соглашение об аренде вычислительных мощностей на сумму около $6,3 млрд, будучи при этом и так крупным клиентом компании, а также с Lambda на $1,5 млрд. Инвесторам и акционерам такие циклические сделки не всегда по нраву, но NVIDIA это даёт определённую гибкость в доступе к вычислительным мощностям. Кроме того, у NVIDIA имеется собственный облачный маркетплейс Lepton для перепродажи ресурсов ИИ-ускорителей.

Источник изображения: Oracle Oracle отметила изменение запросов клиентов, связанных с предоставлением ИИ-сервисов. Так, есть много заказчиков, которые могут подписаться на тысячи ускорителей одного типа, а потом отказаться, желая получить больше мощностей в другом месте. Из-за этого компания вынуждена постоянно перераспределять ускорители между клиентами, попутно наращивая общую мощность. На наращивание мощности для крупного провайдера ИИ-моделей обычно уходит два-три дня. Также Oracle рассказала о добавлении новых регионов Database@Google Cloud. В данном случае уже сама Oracle размещает своё оборудование в ЦОД партнёров. Новые регионы, общее количество которых выросло до 12, появились в Мумбаи, Монреале и Торонто. В следующие 12 мес. компания намерена добавить регионы в Сеуле, Осаке, Дели, Мадриде, Париже, Милане, Турине, Даммаме, Мехико и Сантьяго.

02.12.2025 [09:15], Владимир Мироненко

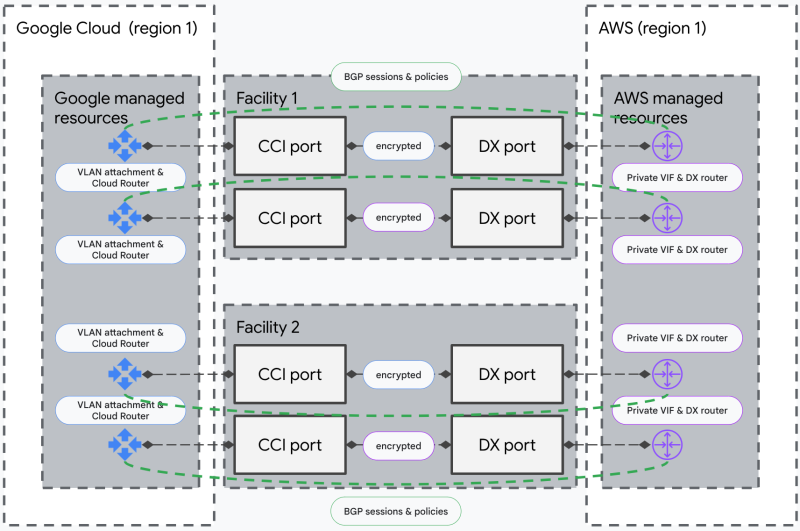

AWS и Google Cloud подружили свои облачные сети, чтобы интернет падал пореже и не у всех сразуAmazon и Google представили мультиоблачный сетевой сервис, разработанный совместными усилиями и призванный удовлетворить растущий спрос на надёжное подключение, в то время как даже кратковременные перебои в работе интернета могут привести к серьезным сбоям в работе сервисов. Новый сервис объединяет AWS Interconnect – multicloud и Google Cross-Cloud Interconnect, предлагая организациям возможность установления защищённых частных высокоскоростных сетевых соединений между Google Cloud и AWS, что обеспечивает онлайн-бизнесу подстраховку в случае сбоя в работе одного из провайдеров. Кроме того, сервис упрощает одновременное использование облачных услуг обоих провайдеров в рамках одного приложения. Теперь компании смогут за считанные минуты установить соединение между вычислительными платформами через выбранную облачную консоль или API. Как отметила Google Cloud, ранее для подключения провайдеров облачных услуг клиентам приходилось вручную настраивать сложные сетевые компоненты, включая физические соединения и оборудование. Это требовало длительного времени на подготовку и координации с несколькими внутренними и внешними командами, и могло занять недели или даже месяцы. Сервис предлагает подключение выбранной ёмкости между двумя облачными регионами обоих провайдеров с четырёхкратным резервированием на уровне ЦОД, пограничных маршрутизаторов и т.д. Оба поставщика осуществляют непрерывный мониторинг для проактивного выявления и устранения проблем, а также совместно управляют резервированием и занимаются эксплуатационной поддержкой. Шифрование MACsec защищает соединения между периферийными маршрутизаторами AWS и Google Cloud. Партнёры также выпустили унифицированный API и открытую спецификацию, предложив другим поставщикам облачных и сетевых услуг фреймворк для интеграции аналогичных мультиоблачных подключений. Благодаря новому сервису клиенты, использующие в работе несколько облаков, получают стандартизированный подход к гибридному перемещению данных, рабочих ИИ-нагрузок и кросс-облачной аналитике.  Salesforce в числе первых внедрила эту технологию. В компании отметили, что интеграция Salesforce Data 360 с более широким ИТ-ландшафтом требует надёжного частного подключения. AWS Interconnect – multicloud позволяет наводить критически важные мосты с Google Cloud с той же лёгкостью, что и развёртывание внутренних ресурсов AWS. В октябре в AWS произошел крупный сбой, который вывел из строя ряд сервисов, включая Fortnite, Alexa и Snapchat. В последующие недели сбои наблюдались и в Microsoft Azure, и в Cloudflare, что вызвало опасения по поводу рисков, связанных с использованием лишь нескольких крупных поставщиков интернет-инфраструктуры. AWS планирует развернуть аналогичный сервис с Microsoft Azure в следующем году. Ранее AWS, Google Cloud и Microsoft Azure уже сделали шаг навстречу другу другу, отказавшись от платы за выгрузку данных при переезде в другое облако.

30.11.2025 [13:39], Владимир Мироненко

Google отозвала жалобу на Microsoft по поводу антиконкурентной практики Azure после запуска расследования в ЕС

google

google cloud platform

microsoft

microsoft azure

software

евросоюз

конкуренция

лицензия

облако

Google отозвала жалобу, поданную в 2024 году в Еврокомиссию в связи с антиконкурентной, по её мнению, практикой лицензирования Microsoft, пишет Reuters. Как утверждалось в жалобе, условия лицензирования делали невыгодным для клиентов облачной платформы Microsoft Azure переход на платформы конкурентов, хотя технических препятствий этому не было. Это произошло спустя несколько дней после того, как Еврокомиссия открыла официальное расследование деятельности Microsoft на европейском рынке облачных услуг, где она занимает второе место с долей 20 %. На первом месте находится Amazon с долей 30 %, а у Google третье место с долей 13 %. В ходе расследования будет тщательно изучено поведение компании на рынке публичных облаков, которое также стало предметом антимонопольной жалобы Google, пишет SiliconANGLE. Помимо расследования деятельности Microsoft, Еврокомиссия начала аналогичное расследование действий AWS на рынке публичных облаков ЕС с целью определения, соответствует ли этот сервис наравне с Microsoft Azure требованиям, предъявляемым к провайдеру услуг базовой платформы (gatekeeper) в рамках закона о цифровых рынках (Digital Markets Act, DMA) ЕС. Кроме того, Европейская комиссия изучит вопрос о том, следует ли изменить DMA, чтобы лучше решать антимонопольные проблемы на облачном рынке. Microsoft предлагает клиентам версию Windows Server, оптимизированную для публичных облачных сред. Многие компании используют её для запуска приложений Microsoft, таких, как SQL Server. В 2019 году Microsoft выпустила крупное обновление условий предоставления услуг тем, кто пользуется Windows Server в облаках конкурентов. В свое жалобе Google утверждала, что изменение лицензирования в 2019 году было антиконкурентным, сделав запуск Windows Server в Google Cloud дороже, чем в Microsoft Azure. При этом Google сослалась на данные исследования, согласно которому пересмотренные Google условия предоставления услуг обошлись компаниям в ЕС более чем в €1 млрд. Кроме того, согласно жалобе поискового гиганта, Microsoft ограничила доступ клиентов к исправлениям Windows Server в конкурирующих облаках и создала препятствия для взаимодействия. «Сегодня мы отзываем жалобу Microsoft в свете недавнего заявления о том, что Еврокомиссия проведёт оценку проблемных практик, влияющих на облачный сектор, в рамках отдельной процедуры», — заявил руководитель отдела по взаимодействию с государственными органами и государственной политике Google Cloud Europe. «Мы продолжаем работать с политиками, клиентами и регулирующими органами в ЕС, Великобритании и других странах, выступая за свободу выбора и открытость на рынке облачных технологий», — добавила Google, по словам которой цель подачи жалобы компании в Еврокомиссию заключалась в том, чтобы «дать возможность клиентам и партнёрам высказаться по вопросу антиконкурентной практики лицензирования облачных сервисов». Согласно DMA, к провайдеру услуг базовой платформы предъявляются более строгие нормативные требования. В одном из положений DMA указано, что сервисы базовой платформы должны предоставлять пользователям простой способ переноса своих данных на другие платформы. Если в результате расследования, на которое отводится год, Еврокомиссия придёт к выводу, что Microsoft Azure является базовой платформой, то Microsoft, возможно, придётся внести изменения в свои инструменты экспорта данных и предоставить потребителям больше возможностей в выборе платформы. Это также относится к расследованию по Amazon Web Services. В свою очередь, как пишет ресурс ceo-na.com, представитель Еврокомиссии заявил следующее: «Мы продолжим внимательно следить за облачным сектором в рамках антимонопольного законодательства, чтобы все европейские потребители и компании могли воспользоваться преимуществами развития облачных технологий».

26.11.2025 [00:54], Владимир Мироненко

Планы Meta✴ использовать ИИ-ускорители Google TPU ударили по акциям NVIDIAВо вторник рынок ценных бумаг компаний в сфере ИИ пришёл в движение после появления в понедельник публикации ресурса The Information о том, что Meta✴ ведёт переговоры с Google об использовании ИИ-ускорителей TPU в её ЦОД в 2027 году. По данным источника ресурса, стороны также обсуждают возможность аренды этих чипов в Google Cloud уже в следующем году, что являются частью более масштабной стратегии Google по привлечению клиентов к использованию TPU в её облаке. Этот шаг ознаменует собой отход от текущей стратегии Google, нацеленной на использование TPU только в собственных ЦОД, что приведёт к обострению конкуренции на многомиллиардном рынке ИИ-ускорителей, отметило агентство Reuters. В Google Cloud предположили, что эта стратегия может помочь компании получить до 10 % годовой выручки NVIDIA, т.е. миллиарды долларов, говорится в публикации The Information. Заключение сделки станет сигналом о растущем спросе на чипы Google и потенциальной возможности бросить в будущем вызов доминированию NVIDIA на рынке, тем более что Google ранее договорилась о поставке Anthropic до 1 млн чипов TPU, пишет Bloomberg. О таком развитии событий аналитики говорили ещё в прошлом году, а уже в этом году появились слухи, что Google готова предложить свои чипы другим провайдерам. Впрочем, Anthropic получила и полмиллиона фирменных ускорителей AWS Trainium. Новость о переговорах вызвала падение во вторник акций NVIDIA на 4,3 %. Акции Alphabet, материнской компании Google, выросли на 4,2 % после более чем 6 % роста в понедельник. Акции Broadcom, участвующей в разработке TPU, выросли более чем на 2 % на премаркете во вторник после роста на 11 % накануне, сообщил CNBC. «Google Cloud испытывает растущий спрос как на наши собственные TPU, так и на GPU NVIDIA; мы намерены поддерживать обе платформы, как и делали это много лет», — заявил представитель Google телеканалу CNBC. Акции AMD, ранее считавшейся наиболее реальным конкурентом NVIDIA на рынке GPU, во вторник упали на 7,5 %. Акции разработчика чипов Arm упали на 4,2 %. Акции компаний в Азии, связанных с Alphabet, выросли в начале торгов во вторник. В Южной Корее акции IsuPetasys Co., которая поставляет многослойные платы для Alphabet, подскочили на 18 %, установив новый рекорд роста в течение дня. На Тайване акции MediaTek выросли почти на 5 %. В последние месяцы Google набрала обороты, сумев привлечь Berkshire Hathaway, принадлежащую Уоррену Баффету (Warren Buffett), в качестве инвестора, превратив облачное подразделение в двигатель роста и получив высокие первые отзывы о своей новейшей модели Gemini 3. Предоставление чипов NVIDIA в аренду клиентам является крупным источником дохода для ее облачного подразделения, пишет Reuters. Чтобы справиться с доминированием NVIDIA, компании потребуется преодолеть почти двадцатилетнюю историю NVIDIA CUDA, которая затрудняет вытеснение её экосистемы. Более 4 млн разработчиков по всему миру используют CUDA для создания ИИ-приложений и других программ. Кроме того, Google должно хватать TPU на всех клиентов. Следует учесть и то, что Meta✴ разрабатывает собственные ИИ-ускорители MTIA. UPD 01.12.2025: Сайнин Се (Saining Xie), бывший сотрудник ИИ-лаборатории Meta✴ FAIR (Fundamental AI Research), сообщил, что Meta✴ использовала Google TPU как минимум с 2020 года, однако из-за малого интереса среди других разработчиков внутри компании в начале 2023 года она отказалась от контракта с Google Cloud. Примерно за год до этого Meta✴ анонсировала создание самого мощного на тот ИИ-суперкомпьютера в мире — RSC (Research SuperCluster).

21.11.2025 [14:56], Руслан Авдеев

Google и Turkcell объединились для создания в Турции облачного региона и постройки первого ЦОД гиперскейл-классаGoogle Cloud и Turkcell займутся совместным созданием облачного региона в Турции с тремя или более зонами доступности. В заявлении Google говорится, что инициатива будет реализована как часть 10-летнего плана компании, предусматривающего инвестиции в объёме $2 млрд в местную инфраструктуру. Turkcell поможет Google Cloud с инфраструктурой в стране, а сама будет перепродавать облачные сервисы. Представитель компании заявил Bloomberg, что речь идёт о первом в Турции дата-центре гиперскейл-класса. В Turkcell рассчитывают, что мощности её ЦОД вырастут более чем вдвое к концу 2032 года, а выручка от дата-центров и облачных сервисов в долларовом эквиваленте за тот же период вырастет в шесть раз. К 2032 году инвестиции компании в дата-центры и облачные технологии составят около $1 млрд. Это поможет укрепить роль Турции в качестве регионального центра цифровых и ИИ-инноваций.

Источник изображения: Youssef Mohamed/unsplash.com Ранее в 2025 году Turkcell получила финансирование на €100 млн ($112,5 млн) для расширения сети дата-центров. На своём сайте компания сообщает, что управляет восьмёркой основных ЦОД на четырёх рынках — в Текирдаге (Tekirdağ), Гебзе (Gebze), Анкаре (Ankara) и Измире (Izmir), общая площадь объектов составляет 122 тыс. м2, включая 32 тыс. м2 свободной площади, совокупная мощность составляет 41,5 МВт. На момент получения средств компания намеревалась увеличить сеть ЦОД ещё на 8,4 МВт к концу 2025 года. Большинство ЦОД в Турции расположены неподалёку от Стамбула, в Анкаре есть небольшой второстепенный рынок. В стране действуют операторы Equinix, Sparkle, TurkNet и ComNet, а также другие компании. Активность проявляют не только компании американского и турецкого происхождения. Например, в июне 2025 года появилась информация, что принадлежащая китайской Alibaba турецкая Trendyol Group построит дата-центр на 48 МВт в Анкаре.

18.11.2025 [17:07], Руслан Авдеев

Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантовЕвросоюз рассматривает возможность ужесточения контроля за деятельностью облачных гигантов AWS, Microsoft Azure и Google Cloud, передаёт Bloomberg. Анитимонополные регуляторы намерены принять решение, следует ли ввести дополнительные ограничения для кого-либо из этих гиперскейлеров в соответствии с действующим в ЕС законом Digital Markets Act (DMA), сообщает издание со ссылкой на источники, «знакомые с ситуацией». План расследования разработан после ряда крупных сбоев в облачном секторе — они привели к хаосу в работе глобальных служб и стали дополнительным свидетельством того, что не стоит опираться лишь на нескольких крупных игроков. Речь о крупных сбоях AWS и Microsoft Azure. Пока облачные гиперскейлеры не подпадали под действие DMA, поскольку большая часть их деятельности связана с корпоративными контрактами, что затрудняет подсчёт индивидуальных пользователей их сервисов. Именно их количество может послужить для ЕС одним из главных оснований для введения дополнительного надзора за облачными сервисами из США.

Источник изображения: Jon Del Rivero/unspalsh.com В рамках расследования регуляторы оценят, стоит ли заставлять ведущих операторов брать на себя новые обязательства, включая повышение уровня совместимости с конкурирующим ПО (что особенно актуально для Microsoft) и упрощение переноса данных пользователей от одного облачного провайдера к другому. Кроме того, не исключены запреты на обязательную продажу пакетов услуг или ПО без возможности купить их по отдельности, а также ограничения на стимулирование подобных «пакетных» продаж. Еврокомиссия и представители гиперскейлеров ситуацию пока не комментируют. Закон DMA, принятый ЕС в 2023 году, призван ограничить деятельность крупнейших IT-гигантов, устанавливая ряд правил и запретов. Пока они не применялись против крупных облачных провайдеров, контролирующих значительную долю рынка. Если облачные сервисы в итоге будут признаны подпадающими под правила DMA, штрафы за их нарушения могут быть весьма чувствительными даже для гиперскейлеров. Например, Apple и Meta✴ уже почувствовали жёсткость закона на себе, заплатив штрафы €500 млн ($579 млн) и €200 млн ($231 млн) соответственно. |

|